De récentes expériences ont montré que les visages humains synthétiques générés grâce à l’intelligence artificielle trompaient même des observateurs entraînés, qui les considéraient comme « plus dignes de confiance » que ceux de personnes bien réelles.

Des résultats surprenants

Les programmes d’IA appelés réseaux antagonistes génératifs, ou GAN, peuvent apprendre à créer de fausses images qui se distinguent de moins en moins des images réelles, en opposant deux réseaux neuronaux. Pour cette nouvelle étude parue dans la revue PNAS, des chercheurs britanniques et américains ont mené différentes expériences dans lesquelles les participants étaient invités à distinguer les visages de synthèse des vrais, et à juger le « niveau de confiance » qu’ils inspiraient.

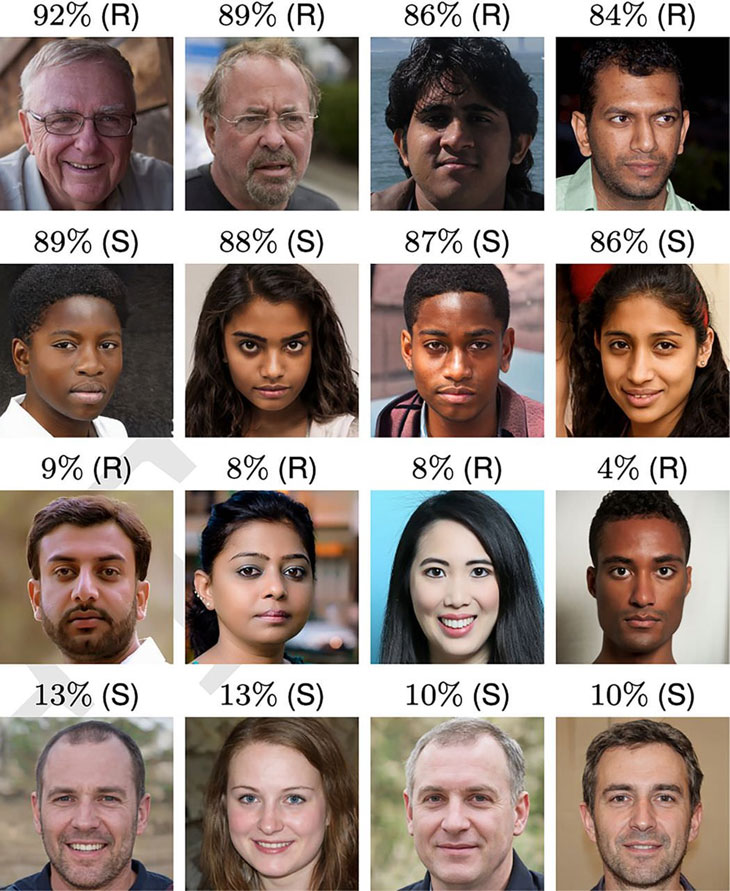

La première a impliqué 315 participants, qui devaient distinguer les portraits « artificiels » de ceux des véritables individus parmi une sélection de 128 clichés. Le groupe a obtenu un taux de précision global de 48,2 %, soit un peu moins que le hasard.

Dans la seconde, 219 nouveaux participants, préalablement briefés sur la façon de distinguer les vrais visages des faux, ont été invités à réaliser la même tâche, obtenant cette fois un taux de précision de 59 %, ce qui constituait selon les auteurs de l’étude une différence négligeable par rapport au premier groupe.

Un autre groupe de 223 personnes a été recruté pour la troisième, qui consistait cette fois à évaluer le degré de fiabilité des mêmes visages, sur une échelle de 1 à 7. De façon surprenante, les participants ont jugé les visages générés numériquement comme étant 8 % plus dignes de confiance que les vrais. Une différence qualifiée de « significative » par les chercheurs, qui pourrait s’expliquer par le fait que les visages synthétiques ressemblent davantage à des visages humains « typiques ».

« Les algorithmes de synthèse ont traversé la vallée de l’étrange »

« Notre évaluation du photoréalisme des visages générés par l’IA indique que les algorithmes de synthèse ont traversé la vallée de l’étrange et sont capables de créer des visages indiscernables, et plus fiables, que les vrais », détaille Sophie Nightingale, chercheuse à l’université de Lancaster et auteure principale de l’étude.

« De tels résultats soulignent la nécessité de cadres éthiques et juridiques plus nombreux et stricts, car il y aura inévitablement des personnes qui voudront utiliser ces images à des fins malveillantes », poursuit-elle.

Selon les scientifiques, l’ajout automatique de filigranes aux images générées par des réseaux de synthèse (incluant les deep fakes) pourrait grandement faciliter leur identification.

Par Yann Contegat, le

Source: New Scientist

Étiquettes: visage, IA, confiance, deepfake

Catégories: Actualités, Robots & IA