Un rapport émanant du Conseil de sécurité des Nations unies en Libye a récemment affirmé qu’un drone tueur autonome avait attaqué des cibles humaines sans en avoir reçu préalablement l’ordre.

Une situation inédite

Le document de 548 pages met en cause le drone militaire autonome Kargu-2, produit par la société turque de technologie militaire STM. Décrit comme un appareil de patrouille, celui-ci utilise une classification d’objets basés sur l’apprentissage automatique afin d’identifier et d’engager des cibles, et peut également opérer avec coopération avec une vingtaine d’autres drones.

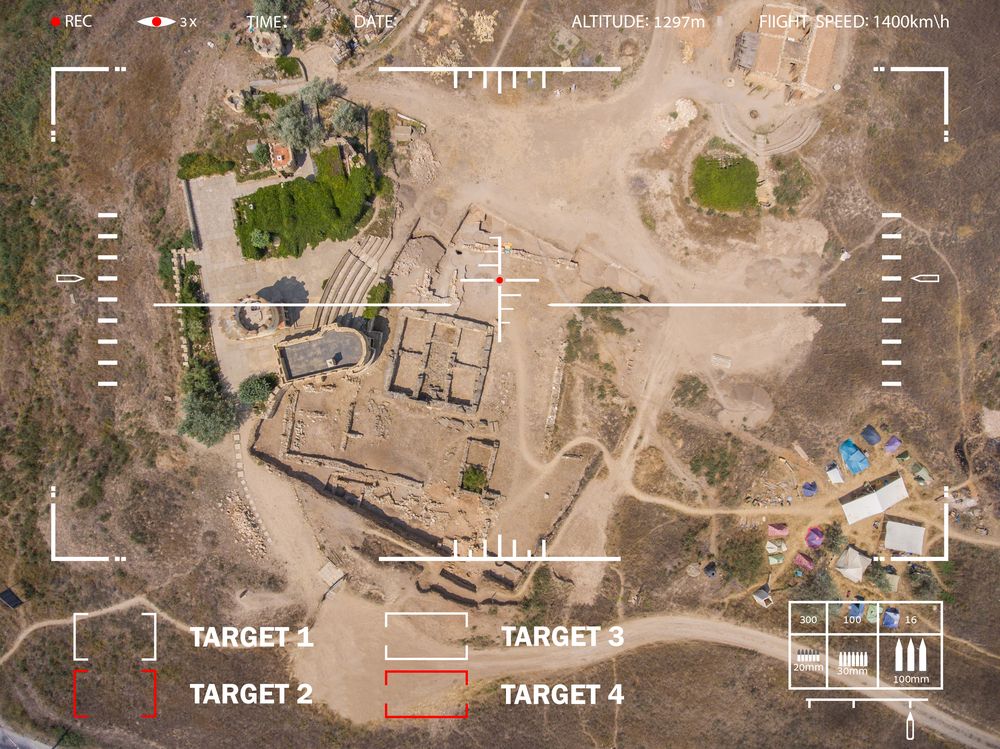

L’an dernier, le gouvernement d’entente nationale reconnu par l’ONU avait repoussé les forces affiliées au général Khalifa Haftar (HAF) de Tripoli, capitale de la Libye. D’après les experts, le drone, qui pourrait être opérationnel depuis janvier 2020, aurait attaqué des soldats fidèles à Haftar. « Les convois logistiques et les HAF battant en retraite ont été traqués et engagés à distance par les drones de combat ou les systèmes d’armes autonomes létaux tels que le STM Kargu-2 », souligne le rapport de l’ONU.

Bien que les auteurs du rapport n’aient pas précisé si l’incident avait fait des victimes, il soulève d’importantes inquiétudes concernant ce type d’appareils, décrits comme « des systèmes d’armes autonomes létaux spécifiquement programmés pour attaquer des cibles sans nécessiter de liaison de données entre l’opérateur et l’appareil ».

Ces dernières années, de nombreux chercheurs en robotique et en IA ont demandé l’interdiction des « armes autonomes offensives », mettant en garde contre le fait que les ensembles de données utilisés pour former ces robots tueurs autonomes puissent se révéler insuffisamment précis ou robustes.

Des risques de défaillances en cascade

Qualifié d’opaque et comparé à une « boîte noire », le processus de prise de décision des systèmes d’IA embarqués par ces appareils implique un risque réel que des drones militaires entièrement autonomes exécutent les mauvaises cibles ou s’attaquent à des civils. Les raisons exactes se révélant ensuite difficiles à établir.

Selon Zachary Kallenborn, consultant en sécurité spécialisé dans les drones, le risque de dérapage se révèle plus élevé lorsque plusieurs drones autonomes communiquent et coordonnent leurs actions.

« La communication au sein d’un essaim de drone crée des risques de défaillances en cascade, avec une erreur commise par une unité et partagée par une autre », souligne-t-il. « Si quelqu’un était tué, cela représenterait probablement un premier cas historique pour ces systèmes militaires autonomes basés sur l’intelligence artificielle. »

Par Yann Contegat, le

Source: The Independent

Étiquettes: drone, autonome, militaire, onu, tueur, kargu-2, libye

Catégories: Actualités, Appareils & Gadgets

Le début de la fin !!!! On joue les apprentis sorciers et après les bavures peu auront le courage d’assumer leurs responsabilités….. Comme d’habitude (cf Covid par exemple et pour ne citer que le dernier cas en cours)