Grâce aux lois de la mécanique quantique, l’« informatique quantique » est aujourd’hui en plein développement. Elle permet de résoudre des problèmes trop compliqués pour les ordinateurs classiques. Cependant, le taux d’erreur de cette technologie est encore élevé. Mais les chercheurs du Quantum AI de Google ont démontré qu’un système utilisant un code correcteur d’erreurs peut détecter et corriger les erreurs sans endommager les données.

Qu’est-ce que l’informatique quantique ?

La mécanique quantique est une branche de la physique qui analyse les particules atomiques et subatomiques. Pour contourner les contraintes du calcul classique, l’informatique quantique fait appel à notre compréhension de la mécanique quantique.

L’effet tunnel qui affecte les programmes actuels à l’échelle nanométrique est éliminé par l’informatique quantique. Toutefois, des problèmes évidents d’évolutivité et de décohérence se posent en pratique.

Le qubit, par opposition au bit traditionnel, est l’unité d’information fondamentale de l’informatique quantique. Contrairement aux bits, qui ne peuvent prendre qu’une seule valeur à la fois (un ou zéro), cette approche alternative permet la superposition cohérente de uns et de zéros, les chiffres binaires sur lesquels repose tout calcul.

En raison d’une propriété de la technologie quantique, un qubit peut être à la fois zéro et un en même temps, dans des proportions différentes. Par exemple, un ordinateur quantique comportant seulement 30 qubits pourrait effectuer 10 000 milliards d’opérations en virgule flottante par seconde.

L’informatique conventionnelle et quantique

Les superordinateurs d’aujourd’hui et les informations qu’ils contiennent en bits sont limités dans leurs possibilités. Le problème est qu’il existe une limite de miniaturisation au-delà de laquelle les micropuces perdent leur fonctionnalité alors qu’elles deviennent plus petites pour atteindre des vitesses de traitement plus rapides.

En raison de sa capacité à fonctionner à l’échelle subatomique, l’informatique quantique a le potentiel d’augmenter considérablement la puissance de traitement au-delà de ce qui est actuellement disponible. Ainsi, de nombreux domaines de la science, de la technologie et de la société en bénéficieraient grandement.

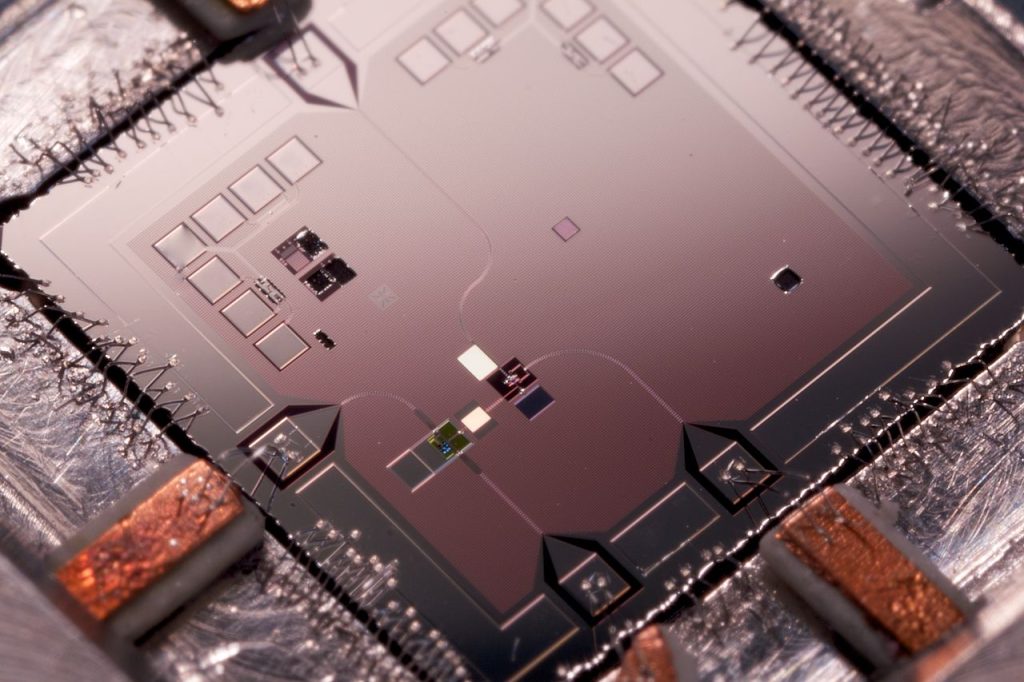

La décohérence, en revanche, peut faire perdre des informations aux qubits lorsqu’ils interagissent avec l’environnement extérieur, ce qui entraîne des taux d’erreur importants. Selon les chercheurs, le processeur Sycamore de troisième génération de Google présente aujourd’hui des taux d’erreur de qubits qui varient généralement de 1 sur 10 000 à 1 sur 100.

Les circuits quantiques doivent fonctionner à des taux compris entre un sur un milliard et un sur un million pour résoudre des problèmes dans une application industrielle. Lors d’une conférence de presse, Hartmut Neven, coauteur du rapport de Google sur l’IA quantique, a déclaré : “Mais si tous les composants de votre système ont des taux d’erreur suffisamment faibles, alors la magie de la correction d’erreurs quantiques entre en jeu.”

Des progrès réels de l’informatique quantique

L’équipe de Google a affirmé avoir pu démontrer, pour la première fois en pratique, qu’un système de correction d’erreurs pouvait trouver et corriger des erreurs sans endommager les données. Ils ont montré que les taux d’erreur par cycle étaient proches de 1 sur 1 million. Ils ont suggéré qu’en réduisant ces sources d’erreur, des taux d’erreur plus proches de 1 sur 10 millions pourraient être atteints.

La correction d’erreurs quantiques est la technologie la plus cruciale pour l’avenir de l’informatique quantique, selon Julian Kelly, un autre co-auteur, qui a salué cette avancée comme « une étape scientifique critique ». M. Neven a déclaré : « Nous devons passer à un taux d’erreur absolument faible », car le résultat n’est toujours « pas assez bon ». Pour atteindre l’objectif d’un ordinateur quantique pratique, a-t-il poursuivi, « il y a d’autres étapes à franchir ».

La voie à suivre pour atteindre les taux d’erreurs logiques nécessaires au traitement est éclairée par ces résultats. Ils constituent une démonstration expérimentale que la correction d’erreurs quantiques commence à mieux fonctionner avec un plus grand nombre de qubits.

Par Eric Rafidiarimanana, le

Source: Science Alert

Étiquettes: informatique quantique, google

Catégories: Technologie, Articles