On a rapporté un comportement agressif chez une des intelligence artificielle développée par une entreprise appartenant à Google. Une découverte qui pourrait avoir des conséquences pour le futur.

UNE INTELLIGENCE ARTIFICIELLE DEDOUBLÉE

L’entreprise DeepMind est une entreprise spécialisée dans la fabrication d’intelligences artificielles (IA) depuis 2010. En 2014, elle a été rachetée par Google et a depuis participé à la fabrication de nombreuses IA dont AlphaGo qui a particulièrement fait parler d’elle. En 2016, elle avait vaincu le champion du monde de Go, un jeu de stratégie japonais qui était soi-disant impossible à analyser par les IA compte tenu de la multiplicité de situations possibles.

Aujourd’hui, DeepMind est sur un autre projet. Ils ont doublé le même programme d’IA pour en faire deux équipes distinctes : Rouge et Bleue ; et elles ont été testées sur deux scénarios différents. Dans le premier, les deux équipes ont été envoyées, armées de lasers, dans une zone virtuelle remplie de pommes avec pour mission de les récolter. Si les deux IA ont d’abord récolté une quantité égale de pommes sans trop de problèmes, à mesure que le nombre de ressources disponibles diminuait, elles ont commencé à s’attaquer l’une et l’autre pour en récolter le plus possible. Dans le second scénario, les deux équipes avaient une même proie à capturer en ayant le choix de coopérer ou non. Deux situations ont alors émergées, une où elles ont chacune chassé leur proie et l’autre où elles se sont entraidées.

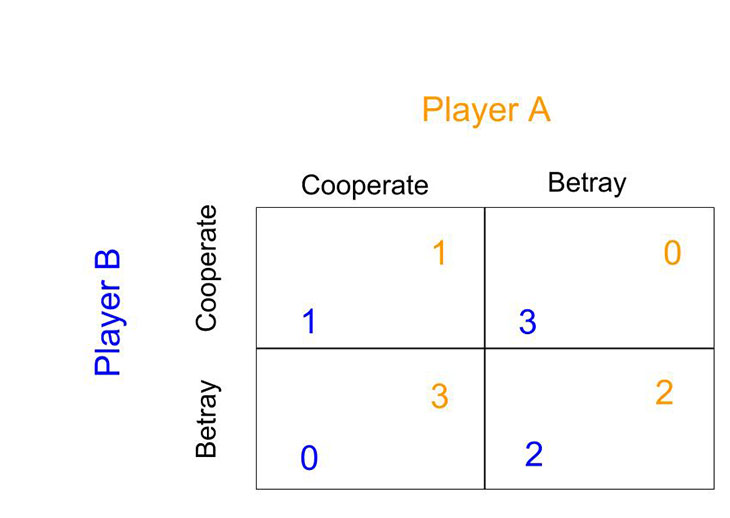

LE DILEMME DU PRISONNIER

Chaque “jeu” se basait sur le principe du dilemme du prisonnier. Il s’agit d’un jeu dans lequel deux joueurs ne peuvent communiquer entre eux mais doivent chacun prendre des décisions qui auront un impact sur leur devenir. Ils peuvent soit coopérer soit se trahir. Dans la plupart des cas, les joueurs choisiront de se trahir car ils pensent que c’est dans leur propre avantage. Si il y en a un des deux qui coopère tandis que l’autre trahit, le coopérateur sera pénalisé (comme si quelqu’un avoue un crime tandis que l’autre clame son innocence). Pourtant s’ils choisissent de tous les deux coopérer ils seront moins pénalisés. Ce théorème est souvent affilié à la notion d’égoïsme et demande à ce que le jeu soit répété plusieurs fois pour voir une situation où les deux joueurs coopèrent.

Il est intéressant de voir que ce théorème, qui analyse le comportement humain, est mis en pratique en utilisant des intelligences artificielles et non pas de vraies personnes. Il est d’ailleurs utilisé dans d’autres domaines comme l’économie ou la psychologie.

UNE LONGUE ROUTE VERS LA COOPÉRATION

Cette expérience de DeepMind a montré qu’il était plus difficile d’obtenir une coopération entre les individus et que l’environnement joue également un rôle important. C’était le cas pour le jeu des pommes dans lequel le manque de ressource a récolté et engendré un comportement agressif de la part d’une des deux IA plutôt qu’une coopération. Le second jeu quant à lui a démontré que la coopération n’était pas un comportement systématique et que son processus d’assimilation par les IA était plus long.

Le fait est que, comme pour les êtres humains, le comportement des IA, en particulier celles utilisant l’apprentissage profond (ou deep learning), ne peut pas être tout à fait déterminé. Élément à prendre en compte, donc, avant de leur confier des tâches qui pourraient avoir un réel impact dans notre vie de tous les jours.

Par Victoria Perez, le

Source: IFLScience!

Étiquettes: google, deepmind, deepmind-ai, dilemme-du-prisonnier, IA, intelligence artificielle

Catégories: Actualités, Robots & IA