Des chercheurs japonais ont modifié une intelligence artificielle génératrice d’images afin qu’elle puisse réaliser cette action en s’appuyant sur des scanners cérébraux plutôt que des commandes textuelles.

Une version modifiée du modèle de Stable Diffusion

Si plusieurs groupes de recherche étaient précédemment parvenus à générer des images à partir de signaux cérébraux, les modèles d’intelligence artificielle utilisés s’avéraient particulièrement complexes. Dans le cadre de travaux pré-publiés sur le serveur BioRxiv, Shinji Nishimoto et Yu Takagi, de l’université d’Osaka, ont mis au point une approche beaucoup plus simple. Impliquant l’IA Stable Diffusion, celle-ci nécessite de renseigner des milliers, et non des millions ou des milliards, de paramètres.

En temps normal, ce générateur d’images à partir de texte modifie un bruit visuel aléatoire en s’appuyant sur les illustrations et clichés de sa base de données possédant des légendes correspondant à la description entrée.

Nishimoto et Takagi ont développé deux modèles supplémentaires pour faire fonctionner l’IA avec des signaux cérébraux. Ils ont utilisé les données de quatre personnes ayant participé à une étude antérieure qui utilisait l’imagerie par résonance magnétique fonctionnelle (IRMf) pour scanner leur cerveau pendant qu’elles regardaient 10 000 images distinctes de paysages, d’objets et de personnes.

En utilisant environ 90 % des données d’imagerie cérébrale, le duo a entraîné un modèle à établir des liens entre les données IRMf d’une région du cerveau traitant les signaux visuels, appelée cortex visuel précoce, et les images que les personnes visualisaient. Le même ensemble de données a ensuite été utilisé pour entraîner un second modèle à établir des liens entre les descriptions textuelles des images et les données IRMf d’une région du cerveau les interprétant, appelée cortex visuel ventral.

Des résultats impressionnants

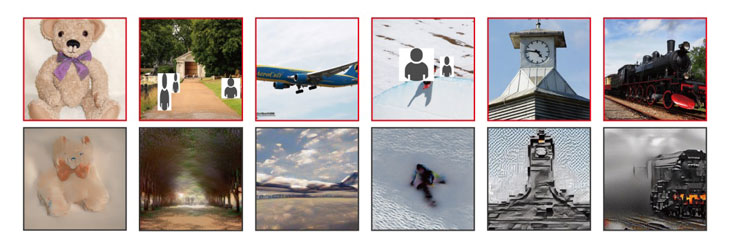

Après entraînement, ces deux modèles ont pu traduire les données d’imagerie cérébrale sous des formes qui ont été directement introduites dans le modèle de Stable Diffusion. L’intelligence artificielle a ensuite pu reconstruire environ 1 000 des images visualisées par les sujets avec une précision de 80 %, sans avoir été préalablement entraînée sur ces dernières.

Ce niveau de précision s’avère similaire à celui obtenu précédemment dans une étude qui analysait les mêmes données en s’appuyant sur une approche beaucoup plus fastidieuse.

S’il convient de souligner que les modèles utilisés étaient spécifiquement adaptés au cerveau de chacun des quatre participants et que de longues séances d’analyse cérébrale à l’aide d’appareils d’IRMf encombrants ont été nécessaires pour parvenir à un tel résultat, les chercheurs estiment que des versions plus « pratiques » du procédé pourraient permettre de traduire fidèlement nos pensées en images.